Une collaboration internationale de longue date entre James S. German (LPL/amU) et Barath Chandrasekaran (University of Pittsburgh) se concrétise au travers d’une étude pluridisciplinaire qui vient d’être publiée dans Nature Communications :

Référence : G. Nike Gnanateja, Kyle Rupp, Fernando Llanos, Jasmine Hect, James S German, Tobias Teichert, Taylor J Abel, Bharath Chandrasekaran. Cortical processing of discrete prosodic patterns in continuous speech. Nature Communications, 2025, 16 (1), pp.1947.

Article en texte intégral : https://www.nature.com/articles/s41467-025-56779-w

Article sur HAL : https://hal.science/hal-04973949v1

Communiqué EurekAlert (AAAS) : https://www.eurekalert.org/news-releases/1075245

Résumé :

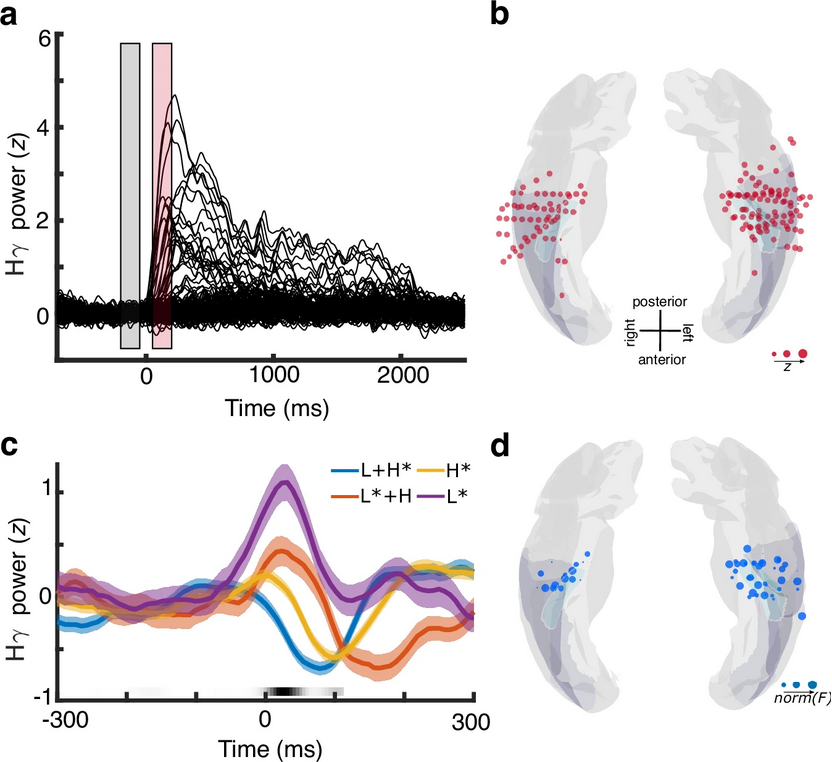

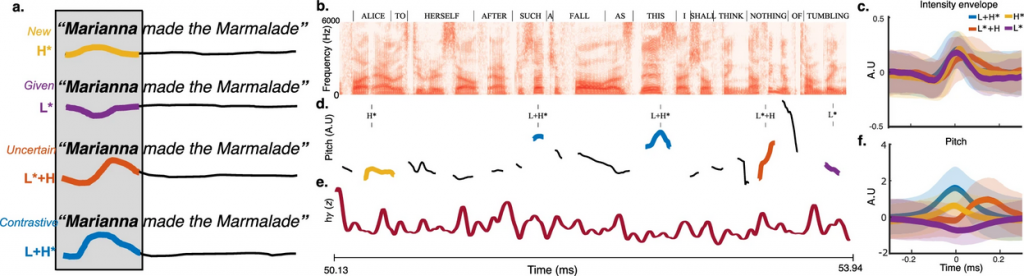

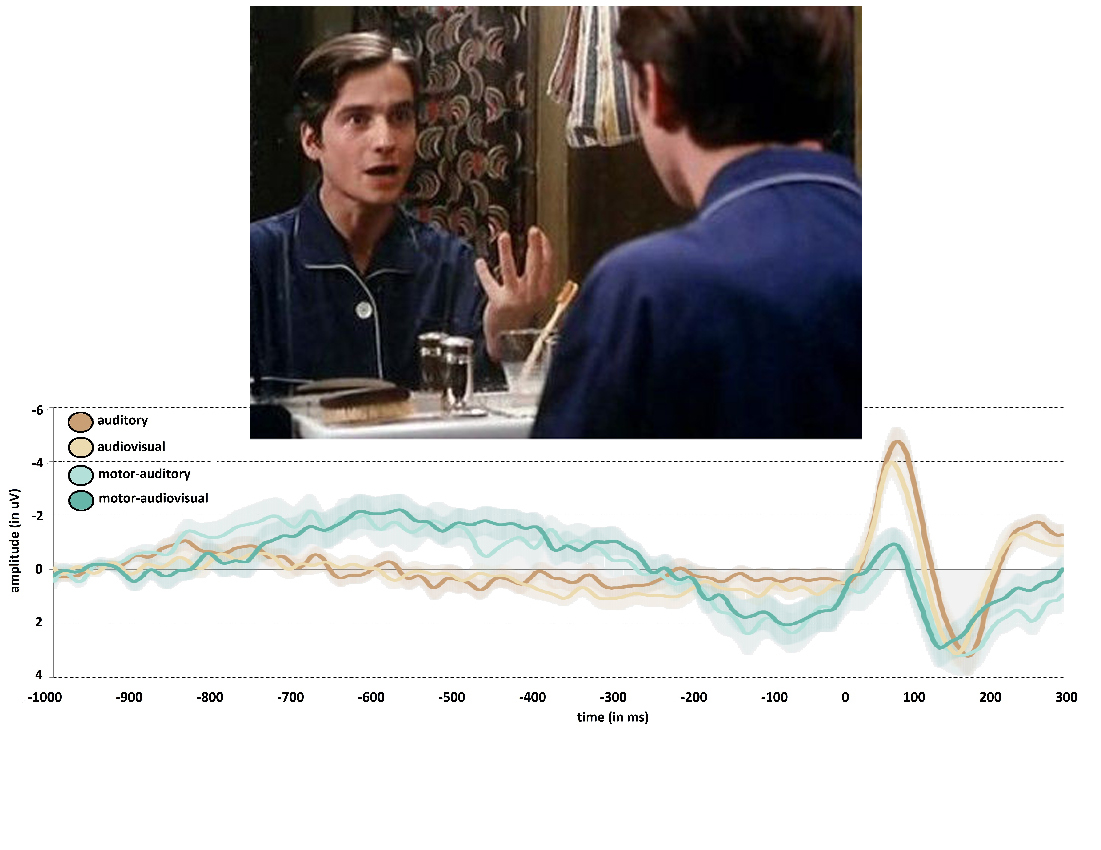

Pendant des années, les scientifiques ont pensé que l’ensemble des aspects de la prosodie étaient essentiellement traités dans le gyrus temporal supérieur, une région du cerveau connue pour la perception de la parole. Grâce à l’analyse d’enregistrements intra-corticaux chez l’humain et le primate-non-humain (Macaque), cette étude révèle que le Gyrus de Heschl est une région corticale cruciale pour la perception de la prosodie qui traite les accents mélodiques en tant qu'unités phonologiques abstraites. Ces résultats informent les modèles neurolinguistiques du traitement de la prosodie en élargissant le rôle du Gyrus de Heschl dans le traitement de la parole au-delà des représentations de bas niveau suggérées jusqu'ici. Ils ont également des implications théoriques importantes pour la linguistique puisque que, conformément à ce qui a été proposé par la théorie auto-segmentale métrique, ils montrent que les accents mélodiques sont des catégories linguistiques de nature discrète.

Description des images 1 et 2

Crédits : Auteurs de l'article