Noël Nguyen, Leonardo Lancia et Lena Huttner du LPL viennent de publier en collaboration avec des chercheurs du GIPSA-Lab et LPNC le premier Registered Report paru dans Glossa Psycholinguistics, une revue Fair Open Access en ligne :

Nguyen, N., Lancia, L., Huttner, L., Schwartz, J., & Diard, J. (2024). Listeners' convergence towards an artificial agent in a joint phoneme categorization task. Glossa Psycholinguistics, 3(1). http://dx.doi.org/10.5070/G6011165

Article en texte intégral : https://escholarship.org/uc/item/0dg0g4kn

Résumé :

Cet article s'inscrit dans le cadre d'un projet visant à répondre à une question très simple : comment se fait-il que nous percevions les mêmes sons de la même manière ? Dans nos interactions langagières, et pour que nous puissions nous comprendre, il est nécessaire que les sons de la parole soient catégorisés de manière similaire par tous les interlocuteurs. Au sein d'une communauté linguistique, il faut ainsi qu'un accord existe entre les locuteurs sur l'emplacement des frontières entre phonèmes parmi les sons de la parole. Cet accord se fonde, pour une part, sur des conventions sociales. Ces conventions s'établissent à l'échelle d'une communauté entière de locuteurs, mais elles ont nécessairement pour origine première un vaste ensemble d'interactions inter-individuelles. Le projet vise ainsi à étudier de manière expérimentale le rôle des interactions inter-individuelles dans la formation d'un espace perceptif partagé.

Nous présentons les premiers éléments d'un modèle computationnel bayésien, qui fait écho au modèle COSMO des intégrations sensori-motrices dans la communication parlée proposé par Jean-Luc Schwartz, Julien Diard, et leurs collaborateurs. Notre modèle a lui pour but de caractériser les mécanismes employés dans la perception conjointe des sons de la parole, chez deux ou plusieurs auditeurs qui accomplissent ensemble une tâche de catégorisation en interagissant les uns avec les autres. Dans ce modèle, une place centrale est ainsi attribuée aux interactions inter-individuelles, et cela constitue une différence majeure au regard des modèles de la perception de la parole élaborés jusqu'à présent.

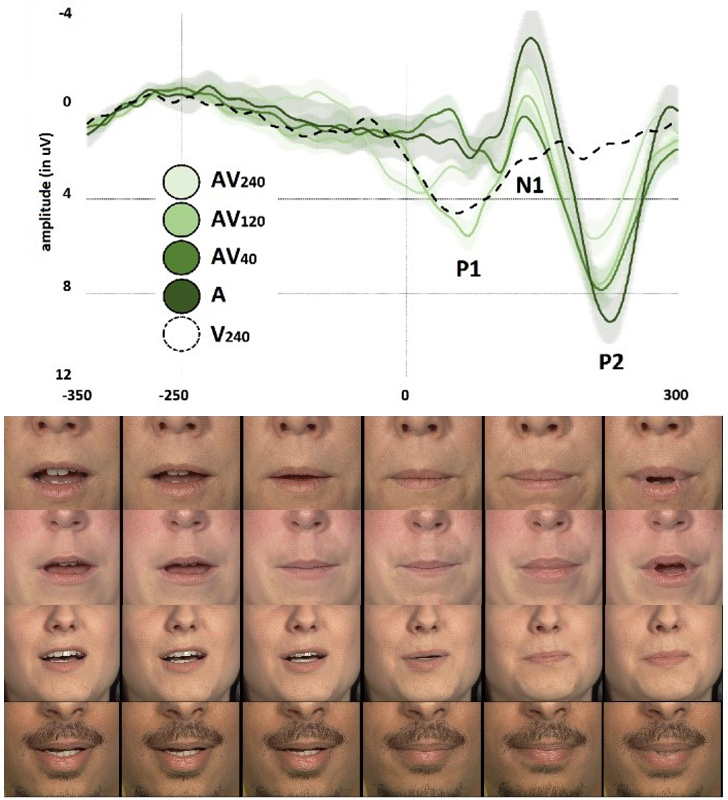

L’expérience présentée a porté sur la perception et la catégorisation des sons de la parole en anglais. La tâche se présentait comme un jeu collaboratif dont l’objectif pour l’auditeur et son partenaire est d’accumuler des points ensemble en catégorisant les sons présentés de façon identique. L’expérience a été réalisée en ligne, et s’il était dit à l’auditeur que celui-ci devra réaliser la tâche avec une autre personne, le partenaire était en réalité un agent artificiel, dont nous avons manipulé les réponses de manière à examiner la sensibilité de l’auditeur à ces manipulations.

Ce travail a été réalisé avec le soutien de l'équipe LSD, du LPL, de l'ILCB, et de l'Institut Carnot Cognition.

Crédits d’image : Les auteurs